2020年精品国产在线:震惊!全球首个AI技术引发伦理争议,专家警告未来可能失控!

最新消息:2023年10月,全球范围内对人工智能技术的伦理问题展开了激烈讨论,许多专家呼吁加强监管,以防止潜在的失控局面。

伦理争议的根源

随着科技的发展,人工智能逐渐渗透到生活的各个方面,从医疗诊断到自动驾驶,再到社交媒体推荐算法,这些技术为人类带来了便利。然而,伴随而来的伦理争议也愈发明显。根据《科学与工程伦理》期刊的一项研究指出,当机器学习系统被用于决策时,其透明度和可解释性往往不足。这使得用户难以理解这些系统如何做出判断,从而引发信任危机。

一些网友对此表示担忧:“我希望我的医生能告诉我,他是如何通过AI来决定我的治疗方案,而不是仅仅依赖一个黑箱。”这种对透明度的需求反映了公众对新技术的不安。在某些情况下,例如面试筛选或贷款审批中使用算法,如果没有适当监督,这可能导致歧视性结果,加剧社会不平等。

专家警告未来风险

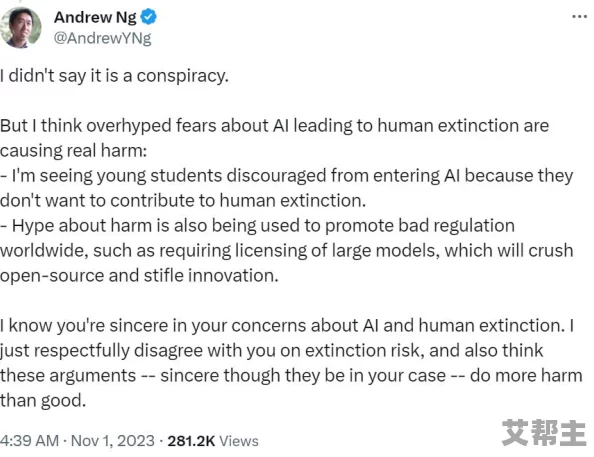

不少专家认为,如果不加以控制,人工智能可能会走向失控。一位知名计算机科学家在一次会议上提到:“我们正在创造一种比我们更聪明的存在,但如果没有相应的道德框架和法律约束,它将成为无法预测和管理的力量。”这一观点引起了广泛关注,并促使相关机构开始重新审视现有政策。

社交媒体上的评论也显示出公众对于未来发展的深切关心。“科技进步固然重要,但人类价值观不能被忽视。我们需要确保这些工具服务于人类,而不是取代人类。”这样的声音越来越多地出现在网络讨论中,也让更多的人意识到了科技与伦理之间的重要联系。

应对措施与建议

为了应对这些挑战,各国政府和组织纷纷提出了一系列建议。例如,美国国家标准与技术研究院(NIST)发布了一份关于人工智能风险管理框架的报告,其中强调了建立透明、可追溯及公平性的必要性。同时,一些企业也开始主动承担社会责任,通过设立内部道德委员会来评估其产品可能带来的影响。

然而,仅靠企业自律并不足够。学者们呼吁制定更加严格且具有前瞻性的法律法规,以确保新兴技术不会偏离其初衷。正如一位评论员所说:“只有当所有利益相关者共同努力,我们才能真正实现科技造福全人类。”

面对如此复杂的问题,不禁让人思考:

如何平衡创新与监管之间的关系?

- 创新是推动社会进步的重要动力,但过度监管又可能抑制发展。因此,需要找到一个合理的界限,让创新在安全可控下进行。

人工智能是否应该具备自主决策能力?

- 目前大多数专家认为,在关键领域,如医疗、司法等,应限制其自主决策能力,以避免不可预见后果。

社会大众如何参与到人工智能治理中?

- 提高公众意识,加强教育,使每个人都能理解并参与有关人工智能发展的讨论,是实现有效治理的重要途径。

参考文献:

- Binns, R. (2018). Fairness in Machine Learning: Lessons from Political Philosophy.

- Jobin, A., Ienca, M., & Andorno, R. (2019). Artificial Intelligence: The Global Landscape of Ethics Guidelines.

- Dignum, V. (2019). Responsible Artificial Intelligence: Designing AI for Human Values.